人类幻觉比AI要严重多了

人们很容易对深度搜索、元宝、ChatGPT等AI产品吹毛求疵,批评最多的就是AI幻觉,通俗说就是你问AI一个问题,对方回答振振有词,语气流畅,内容充实,但其中有的内容是捏造的,弄得你对它半信半疑。

要了解AI幻觉为何产生,先得了解AI模型主要是通过从数据中寻找规律来学习进行预测。按照谷歌对AI产生幻觉的官方解释,其原因主要有两条:AI模型在学习过程中,可能会捕捉到数据中的偏见和噪音,这些偏见和噪音会被误认为是有规律的 patterns,从而导致AI模型产生错误的预测结果。

核心是训练数据的质量和完整性。如果训练数据不完整、有偏差或存在其他缺陷,AI 模型可能会学习错误的模式,导致预测不准确或出现幻觉。例如,基于医学图片数据集训练的 AI 模型可能会学习识别癌细胞。但是,如果数据集中不包含任何健康组织的图片,AI 模型可能会错误地预测健康组织会癌变,这将导致严重的医疗后果。

AI 模型可能难以准确理解现实世界的知识、物理属性或事实信息。缺乏依据可能会导致模型生成看似合理的输出,但其实是不正确、不相关或无意义的内容。这甚至还包括编造指向从未存在过的网页的链接。例如,用于生成新闻报道摘要的 AI 模型可能会生成包含原始报道中未包含的详情的摘要,甚至完全虚构信息。

如果说AI模型回答问题的准确性,主要依赖于训练数据的质量和多样性,但他们又不能主动验证信息的真实性,那么从理论上来讲,人类可以通过批判性思维和多源信息验证来评估信息的准确性,但事实果真如此吗?

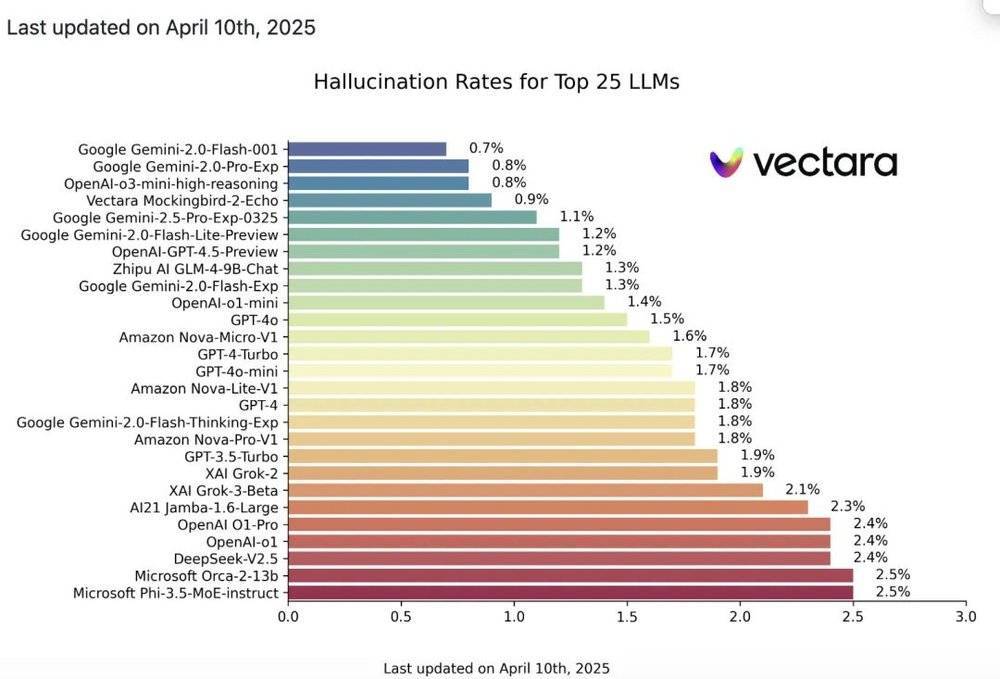

Vectara 在 2025 年 3 月对目前市场上主流的 AI 大模型进行了测试,结果发现大部分主流大模型产品的幻觉率都处于一个相对较低的水平。其中,Gemini-2.0-Flash-001 的幻觉率最低,为 0.7%,在处理文档时几乎没有引入虚假信息,显示出其优异的性能。此外,Gemini-2.0-Pro-Exp 和 OpenAI 的 o3-mini-high-reasoning 模型也紧随其后,以 0.8% 的幻觉率位居第二。

这种幻觉率已经远低于我们人类中的专业精英了。当前顶尖的大模型在知识密集型任务和结构化场景中,已超越人类专家的性能,只是在开放性创造和现实经验依赖型任务上仍存在一定的差距。

以医学为例,世界卫生组织曾经发布了一项报告,揭示临床医学的平均误诊率为30%,其中,思维和认识错误导致的医疗失误占了80%。《中国罕见病综合社会调查》2020-2021数据也表明,国内罕见病的平均确诊时间为4.26年,并且误诊率高达42%。

医疗是人类幻觉的一个缩影。从宏观角度来看,人类的认知偏见和误解远远超过了大模型。这实际上是与我们人类的大脑处理信息的方式、认知偏见以及外部环境的影响相关,也是我们生物局限性的必然结果。人类产生幻觉的原因比AI幻觉的病根要多得多。

人类 tends to seek, explain and remember information that supports their existing beliefs, while ignoring or underestimating conflicting information. Humans rely on easily accessible information to judge the probability or frequency of an event, which can lead to inaccurate judgments. When making decisions, we often rely too heavily on the initial information we receive (anchoring effect), even if subsequent information may be more important. For example, the RMS Titanic was considered an "unsinkable" ship, and its crew and management underestimated the danger of icebergs, ultimately leading to its tragic maiden voyage sinking and claiming the lives of over 1,500 people.

当面对大量信息时,人类可能难以有效地处理和筛选,导致信息误解或错误判断。事实证明,1986年前苏联切尔诺贝利核电站的操作人员在进行安全测试时,忽视了多项安全协议和警告信号,导致了历史上最严重的核电站事故之一,造成大量辐射泄漏。事故发生后,普里皮亚季和切尔诺贝利一直被形容为一座“鬼城”,其周围的2000多平方公里范围接近无人区。

人类的情绪状态和个体动机往往会对信息处理和决策产生潜在影响。例如,人们在感到焦虑时可能会对风险进行过度评估,而在感受到乐观时则可能会低估风险。这种情绪因素的影响曾经导致悲剧的错误判断,例如2003年美国及其盟国基于错误的情报判断,误认为伊拉克拥有大规模杀伤性武器,从而发动了对伊拉克的军事入侵,结果导致了长期的地区不稳定和大量人员伤亡,但最终未能找到大规模杀伤性武器。

即使是拥有巨大权力和影响力的人物,也可能因为认知偏见、错误判断或忽视警告而导致严重后果。欧洲历史上曾经发生过的猎巫事件、纳粹屠杀悲剧,以及美国总统特朗普最近发起的关税战,就是人类认知偏见和错误判断所引发的一系列危机的典型案例。

特朗普在演讲中曾表示:“多年来,当其他国家日益 процвет和强大时,辛勤工作的美国公民却被迫袖手旁观,其中大部分是以我们的利益为代价……现在轮到我们繁荣发展了。”

这种言论,即使是美国的铁杆盟友英国老牌的《经济学人》杂志也无法不对其进行一些批评:“特朗普轻易地忽视了两个事实:全球化为美国带来了前所未有的繁荣,美国一直是国际贸易规则的主要制定者。如今,如果特朗普的愿望实现,那么自二战后缓慢而稳步建立起来的经济秩序将被埋葬。相反,特朗普却赞扬了 19 世纪末美国的繁荣,那时美国比今天贫穷得多。”

位高权重如美国总统也无法从自我认知偏见中爬出来,信息差更大的普通人的幻觉程度又如何?就像神经科学家达马西奥所说:“人不是可以感受的思维机器,而是可以思维的感受机器。”这句话读起来绕口,但你多看两眼,就会察觉这句话的精妙之处。