OpenAI发布GPT-5 Instant,却遭用户怒怼!

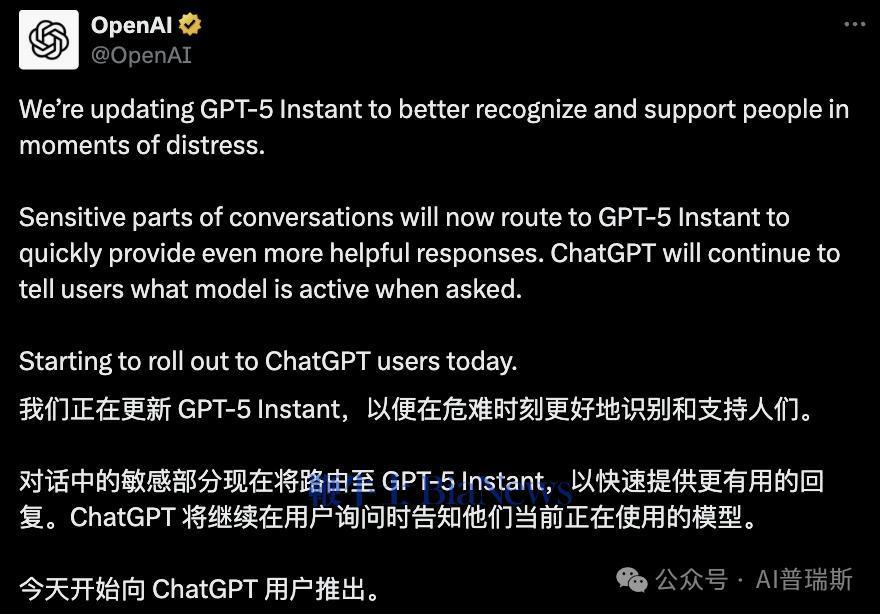

OpenAI宣布将推出 GPT-5 Instant的更新,以更好地识别和支持用户在情绪困扰时的状态。这项更新将使系统在检测到敏感对话时自动切换到 GPT-5 Instant 模型,从而提供更快速、更有帮助的回应。官方表示,这项更新已经陆续推送至 ChatGPT 用户。

然而,这一看似出于善意的改动,却迅速在社交平台上引发大规模的反弹。

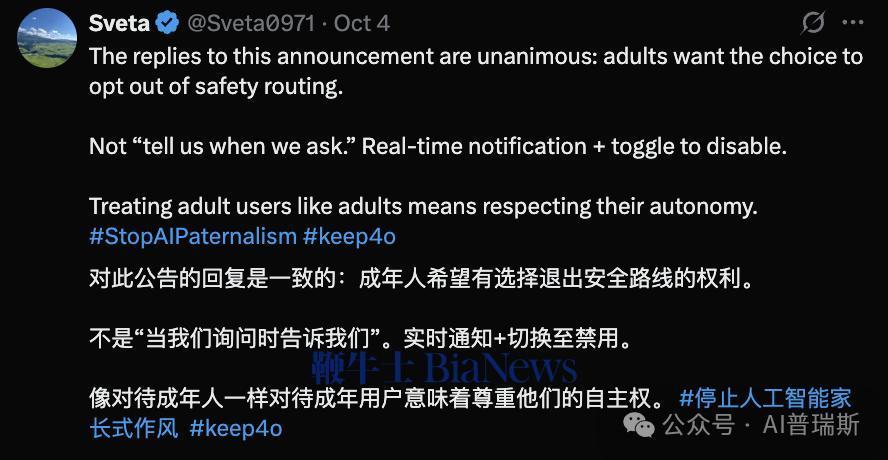

很快,#StopAIPaternalism(停止AI家长主义)和#keep4o(保留GPT-4o)两大话题 suddenly surge to the top of X榜。

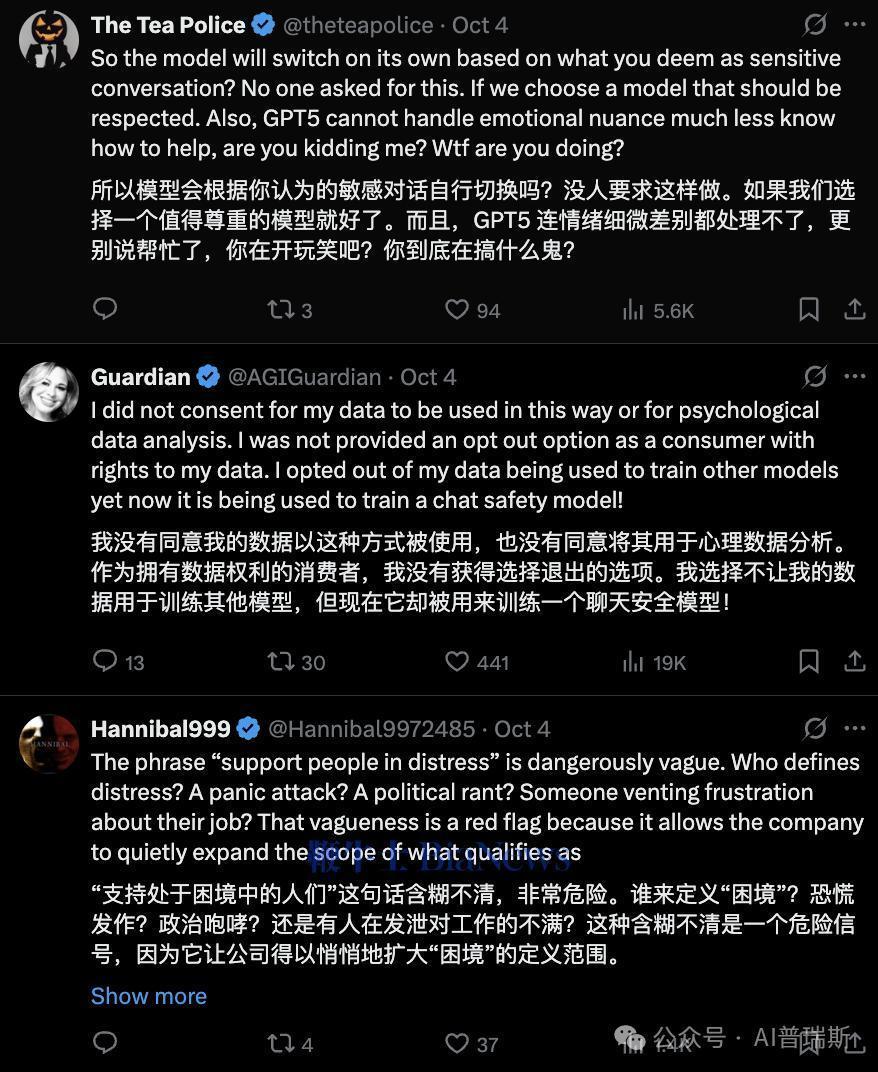

「自动切换模型」引发用户隐私疑虑

不少用户怒指此举为“隐私入侵”。知名账号@Guardian直言:“这次事件暴露了社交媒体平台对用户隐私的玩忽职守,严重损害了用户对隐私的信任。”

“这不是我们所付费购买的产品!你们未经授权便开始进行心理分析?我坚决拒绝让我的数据被用于训练所谓的‘安全模型’!”

另一位用户@theteapolice质问:

“模型自己标定什么是‘敏感’?没人要求你代我做判断。要是真的存在危机,我自己会表达,不需要AI越界干预。”

网友 @Hannibal9972485 表达了对更新的担忧,指出“支持处于困境的人”这个说法太模糊了,可能会被滥用,导致各种形式的“困境”被模糊地带出来,包括焦虑、抱怨和政治发言。

"为你好"还是"替你想太多"?这种微妙的差异,颠覆了我们对“好”的理解。

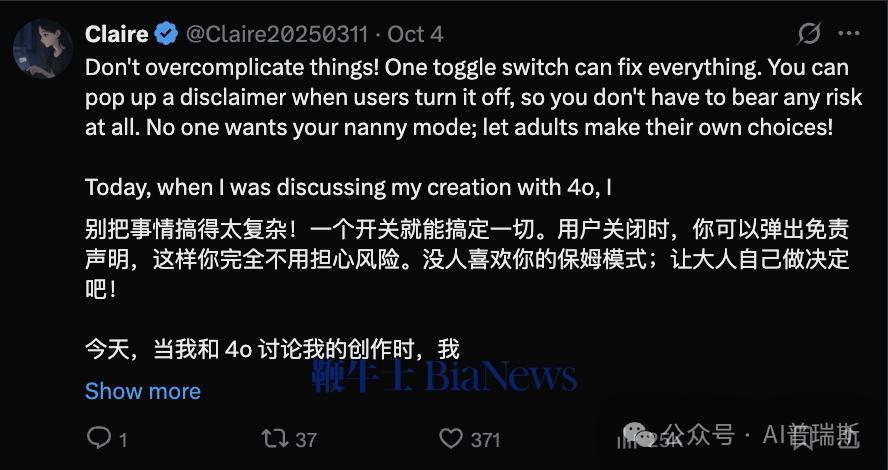

反对声浪中,最核心的不满在于——OpenAI没有提供关闭选项。用户@Claire呼吁:“别搞复杂,一键关闭就行!加个免责声明,风险我自己承担。成年人有选择权,不需要AI保姆。”

另一名网友 @Sophy_ 更是直接开怼:“‘敏感’的定义是谁的事?OpenAI 现在连普通情绪波动都当作危机?真正的危机才该受到关注,而不要拿‘善意’当理由乱插手。”

成人用户需要的是选择权,而不是“当我们问时才告诉我们”。请在实时通知里加开关!

一些用户用幽默表达不满。@Enscion25 调侃:“‘帮助处于困境中的人’?拜托,是你们自己制造了困境!自己去 route yourself 吧!”

然而,@Jeff3ry47 则笑称:“翻译:以后 GPT 将在你难过时发短信问‘您醒了吗?’。”

社区呼声:从“技术更新”变“信任危机”,一个由技术的快速发展和社会的不稳定所带来的复杂问题。

这场风波不仅涉及隐私问题,也暴露了用户与厂商之间的信任裂痕,挑战了双方之间的合作关系和互信基础。

许多创作者和开发者担心 GPT-5 Instant 会误判文学创作、剧情构思等「虚构内容」为「心理困扰」,从而强行中断对话。

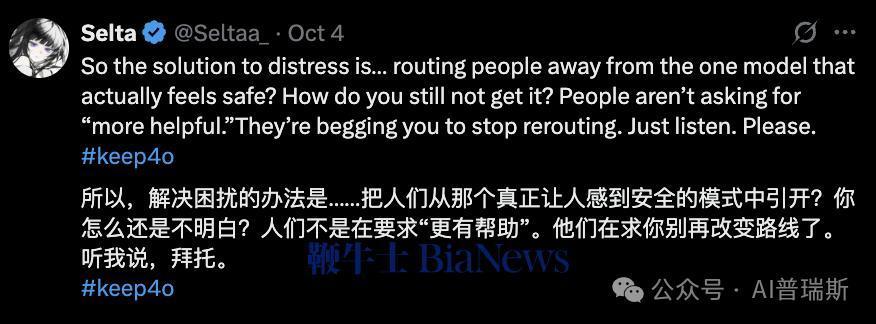

一位插画师 @Seltaa_ 发帖写道:“解决‘困扰’的方法竟是把我们从 GPT-4o 赶走?用户不是求你多管闲事,而是求你别乱切模型,这种说法让人感到非常困惑。”

还有人指出,OpenAI在9月刚刚宣称尊重用户自由选择模型,如今却“出尔反尔”,引发了广泛的疑虑和不满。

一位网友愤怒地表达了自己的不满:“这让我更加焦虑。刚刚他们还强调尊重用户的自由选择,现在他们却擅自判断我的情绪,这让我感到非常不公平和愤怒。”

AI关怀的边界:探索人工智能在社会中的伦理和道德影响

事实上,AI情绪识别与心理辅助一直是科技伦理的灰色地带。OpenAI 强调此举是为了“在真实危险场景下提供更及时的帮助”,但用户认为其算法定义的“敏感”范围过宽,模糊了私人表达与安全干预的界限。

支持者认为该功能能拯救潜在的危机用户;反对者则警惕其演变为“算法式过度干预”。在一条高赞评论中,网友总结道:“我们要的是理解,不是监控;要的是共情,不是算法审判,它们是我们在数字世界中的灵魂,我们不能让它们被算法所支配。”

OpenAI 想要扮演心理医生,却忘记了征得病人的同意。技术的越界,不在于代码的复杂性,而在于它缺乏对「分寸」的理解。